Cleanup Docs languages (#7865)

Signed-off-by: Glenn Jocher <glenn.jocher@ultralytics.com>pull/7861/head

parent

6183b59d8a

commit

afb0cb1057

284 changed files with 8 additions and 40429 deletions

@ -1,127 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erkunden Sie verschiedene von Ultralytics unterstützte Computer Vision Datensätze für Objekterkennung, Segmentierung, Posenschätzung, Bildklassifizierung und Multi-Objekt-Verfolgung. |

||||

keywords: Computer Vision, Datensätze, Ultralytics, YOLO, Objekterkennung, Instanzsegmentierung, Posenschätzung, Bildklassifizierung, Multi-Objekt-Verfolgung |

||||

--- |

||||

|

||||

# Übersicht über Datensätze |

||||

|

||||

Ultralytics bietet Unterstützung für verschiedene Datensätze an, um Computervisionsaufgaben wie Erkennung, Instanzsegmentierung, Posenschätzung, Klassifizierung und Verfolgung mehrerer Objekte zu erleichtern. Unten finden Sie eine Liste der wichtigsten Ultralytics-Datensätze, gefolgt von einer Zusammenfassung jeder Computervisionsaufgabe und den jeweiligen Datensätzen. |

||||

|

||||

!!! Note "Hinweis" |

||||

|

||||

🚧 Unsere mehrsprachige Dokumentation befindet sich derzeit im Aufbau und wir arbeiten intensiv an deren Verbesserung. Vielen Dank für Ihre Geduld! 🙏 |

||||

|

||||

## [Erkennungsdatensätze](../../datasets/detect/index.md) |

||||

|

||||

Die Objekterkennung mittels Bounding Box ist eine Computervisionstechnik, die das Erkennen und Lokalisieren von Objekten in einem Bild anhand des Zeichnens einer Bounding Box um jedes Objekt beinhaltet. |

||||

|

||||

- [Argoverse](../../datasets/detect/argoverse.md): Ein Datensatz mit 3D-Tracking- und Bewegungsvorhersagedaten aus städtischen Umgebungen mit umfassenden Annotationen. |

||||

- [COCO](../../datasets/detect/coco.md): Ein umfangreicher Datensatz für Objekterkennung, Segmentierung und Beschreibung mit über 200.000 beschrifteten Bildern. |

||||

- [COCO8](../../datasets/detect/coco8.md): Enthält die ersten 4 Bilder aus COCO Train und COCO Val, geeignet für schnelle Tests. |

||||

- [Global Wheat 2020](../../datasets/detect/globalwheat2020.md): Ein Datensatz mit Bildern von Weizenköpfen aus aller Welt für Objekterkennungs- und Lokalisierungsaufgaben. |

||||

- [Objects365](../../datasets/detect/objects365.md): Ein hochwertiger, großer Datensatz für Objekterkennung mit 365 Objektkategorien und über 600.000 annotierten Bildern. |

||||

- [OpenImagesV7](../../datasets/detect/open-images-v7.md): Ein umfassender Datensatz von Google mit 1,7 Millionen Trainingsbildern und 42.000 Validierungsbildern. |

||||

- [SKU-110K](../../datasets/detect/sku-110k.md): Ein Datensatz mit dichter Objekterkennung in Einzelhandelsumgebungen mit über 11.000 Bildern und 1,7 Millionen Bounding Boxen. |

||||

- [VisDrone](../../datasets/detect/visdrone.md): Ein Datensatz mit Objekterkennungs- und Multi-Objekt-Tracking-Daten aus Drohnenaufnahmen mit über 10.000 Bildern und Videosequenzen. |

||||

- [VOC](../../datasets/detect/voc.md): Der Pascal Visual Object Classes (VOC) Datensatz für Objekterkennung und Segmentierung mit 20 Objektklassen und über 11.000 Bildern. |

||||

- [xView](../../datasets/detect/xview.md): Ein Datensatz für Objekterkennung in Überwachungsbildern mit 60 Objektkategorien und über 1 Million annotierten Objekten. |

||||

|

||||

## [Datensätze für Instanzsegmentierung](../../datasets/segment/index.md) |

||||

|

||||

Die Instanzsegmentierung ist eine Computervisionstechnik, die das Identifizieren und Lokalisieren von Objekten in einem Bild auf Pixelebene beinhaltet. |

||||

|

||||

- [COCO](../../datasets/segment/coco.md): Ein großer Datensatz für Objekterkennung, Segmentierung und Beschreibungsaufgaben mit über 200.000 beschrifteten Bildern. |

||||

- [COCO8-seg](../../datasets/segment/coco8-seg.md): Ein kleinerer Datensatz für Instanzsegmentierungsaufgaben, der eine Teilmenge von 8 COCO-Bildern mit Segmentierungsannotationen enthält. |

||||

|

||||

## [Posenschätzung](../../datasets/pose/index.md) |

||||

|

||||

Die Posenschätzung ist eine Technik, die verwendet wird, um die Position des Objekts relativ zur Kamera oder zum Weltkoordinatensystem zu bestimmen. |

||||

|

||||

- [COCO](../../datasets/pose/coco.md): Ein großer Datensatz mit menschlichen Pose-Annotationen für Posenschätzungsaufgaben. |

||||

- [COCO8-pose](../../datasets/pose/coco8-pose.md): Ein kleinerer Datensatz für Posenschätzungsaufgaben, der eine Teilmenge von 8 COCO-Bildern mit menschlichen Pose-Annotationen enthält. |

||||

- [Tiger-pose](../../datasets/pose/tiger-pose.md): Ein kompakter Datensatz bestehend aus 263 Bildern, die auf Tiger fokussiert sind, mit Annotationen von 12 Schlüsselpunkten pro Tiger für Posenschätzungsaufgaben. |

||||

|

||||

## [Bildklassifizierung](../../datasets/classify/index.md) |

||||

|

||||

Die Bildklassifizierung ist eine Computervisionsaufgabe, bei der ein Bild basierend auf seinem visuellen Inhalt in eine oder mehrere vordefinierte Klassen oder Kategorien eingeteilt wird. |

||||

|

||||

- [Caltech 101](../../datasets/classify/caltech101.md): Enthält Bilder von 101 Objektkategorien für Bildklassifizierungsaufgaben. |

||||

- [Caltech 256](../../datasets/classify/caltech256.md): Eine erweiterte Version von Caltech 101 mit 256 Objektkategorien und herausfordernderen Bildern. |

||||

- [CIFAR-10](../../datasets/classify/cifar10.md): Ein Datensatz mit 60.000 32x32 Farbbildern in 10 Klassen, mit 6.000 Bildern pro Klasse. |

||||

- [CIFAR-100](../../datasets/classify/cifar100.md): Eine erweiterte Version von CIFAR-10 mit 100 Objektkategorien und 600 Bildern pro Klasse. |

||||

- [Fashion-MNIST](../../datasets/classify/fashion-mnist.md): Ein Datensatz mit 70.000 Graustufenbildern von 10 Modekategorien für Bildklassifizierungsaufgaben. |

||||

- [ImageNet](../../datasets/classify/imagenet.md): Ein großer Datensatz für Objekterkennung und Bildklassifizierung mit über 14 Millionen Bildern und 20.000 Kategorien. |

||||

- [ImageNet-10](../../datasets/classify/imagenet10.md): Ein kleinerer Teildatensatz von ImageNet mit 10 Kategorien für schnelleres Experimentieren und Testen. |

||||

- [Imagenette](../../datasets/classify/imagenette.md): Ein kleinerer Teildatensatz von ImageNet, der 10 leicht unterscheidbare Klassen für ein schnelleres Training und Testen enthält. |

||||

- [Imagewoof](../../datasets/classify/imagewoof.md): Ein herausfordernderer Teildatensatz von ImageNet mit 10 Hundezuchtkategorien für Bildklassifizierungsaufgaben. |

||||

- [MNIST](../../datasets/classify/mnist.md): Ein Datensatz mit 70.000 Graustufenbildern von handgeschriebenen Ziffern für Bildklassifizierungsaufgaben. |

||||

|

||||

## [Orientierte Bounding Boxes (OBB)](../../datasets/obb/index.md) |

||||

|

||||

Orientierte Bounding Boxes (OBB) ist eine Methode in der Computervision für die Erkennung von geneigten Objekten in Bildern mithilfe von rotierten Bounding Boxen, die oft auf Luft- und Satellitenbilder angewendet wird. |

||||

|

||||

- [DOTAv2](../../datasets/obb/dota-v2.md): Ein beliebter OBB-Datensatz für Luftbildaufnahmen mit 1,7 Millionen Instanzen und 11.268 Bildern. |

||||

|

||||

## [Multi-Objekt-Verfolgung](../../datasets/track/index.md) |

||||

|

||||

Die Verfolgung mehrerer Objekte ist eine Computervisionstechnik, die das Erkennen und Verfolgen mehrerer Objekte über die Zeit in einer Videosequenz beinhaltet. |

||||

|

||||

- [Argoverse](../../datasets/detect/argoverse.md): Ein Datensatz mit 3D-Tracking- und Bewegungsvorhersagedaten aus städtischen Umgebungen mit umfassenden Annotationen für Multi-Objekt-Verfolgungsaufgaben. |

||||

- [VisDrone](../../datasets/detect/visdrone.md): Ein Datensatz mit Daten zur Objekterkennung und Multi-Objekt-Verfolgung aus Drohnenaufnahmen mit über 10.000 Bildern und Videosequenzen. |

||||

|

||||

## Neue Datensätze beitragen |

||||

|

||||

Das Bereitstellen eines neuen Datensatzes umfasst mehrere Schritte, um sicherzustellen, dass er gut in die bestehende Infrastruktur integriert werden kann. Unten finden Sie die notwendigen Schritte: |

||||

|

||||

### Schritte um einen neuen Datensatz beizutragen |

||||

|

||||

1. **Bilder sammeln**: Sammeln Sie die Bilder, die zum Datensatz gehören. Diese können von verschiedenen Quellen gesammelt werden, wie öffentlichen Datenbanken oder Ihrer eigenen Sammlung. |

||||

|

||||

2. **Bilder annotieren**: Annotieren Sie diese Bilder mit Bounding Boxen, Segmenten oder Schlüsselpunkten, je nach Aufgabe. |

||||

|

||||

3. **Annotationen exportieren**: Konvertieren Sie diese Annotationen in das von Ultralytics unterstützte YOLO `*.txt`-Dateiformat. |

||||

|

||||

4. **Datensatz organisieren**: Ordnen Sie Ihren Datensatz in die richtige Ordnerstruktur an. Sie sollten übergeordnete Verzeichnisse `train/` und `val/` haben, und innerhalb dieser je ein Unterverzeichnis `images/` und `labels/`. |

||||

|

||||

``` |

||||

dataset/ |

||||

├── train/ |

||||

│ ├── images/ |

||||

│ └── labels/ |

||||

└── val/ |

||||

├── images/ |

||||

└── labels/ |

||||

``` |

||||

|

||||

5. **Eine `data.yaml`-Datei erstellen**: Erstellen Sie in Ihrem Stammverzeichnis des Datensatzes eine Datei `data.yaml`, die den Datensatz, die Klassen und andere notwendige Informationen beschreibt. |

||||

|

||||

6. **Bilder optimieren (Optional)**: Wenn Sie die Größe des Datensatzes für eine effizientere Verarbeitung reduzieren möchten, können Sie die Bilder mit dem untenstehenden Code optimieren. Dies ist nicht erforderlich, wird aber für kleinere Datensatzgrößen und schnellere Download-Geschwindigkeiten empfohlen. |

||||

|

||||

7. **Datensatz zippen**: Komprimieren Sie das gesamte Datensatzverzeichnis in eine Zip-Datei. |

||||

|

||||

8. **Dokumentation und PR**: Erstellen Sie eine Dokumentationsseite, die Ihren Datensatz beschreibt und wie er in das bestehende Framework passt. Danach reichen Sie einen Pull Request (PR) ein. Weitere Details zur Einreichung eines PR finden Sie in den [Ultralytics Beitragshinweisen](https://docs.ultralytics.com/help/contributing). |

||||

|

||||

### Beispielcode zum Optimieren und Zippen eines Datensatzes |

||||

|

||||

!!! Example "Optimieren und Zippen eines Datensatzes" |

||||

|

||||

=== "Python" |

||||

|

||||

```python |

||||

from pathlib import Path |

||||

from ultralytics.data.utils import compress_one_image |

||||

from ultralytics.utils.downloads import zip_directory |

||||

|

||||

# Definieren des Verzeichnisses des Datensatzes |

||||

path = Path('Pfad/zum/Datensatz') |

||||

|

||||

# Bilder im Datensatz optimieren (optional) |

||||

for f in path.rglob('*.jpg'): |

||||

compress_one_image(f) |

||||

|

||||

# Datensatz in 'Pfad/zum/Datensatz.zip' zippen |

||||

zip_directory(path) |

||||

``` |

||||

|

||||

Indem Sie diesen Schritten folgen, können Sie einen neuen Datensatz beitragen, der gut in die bestehende Struktur von Ultralytics integriert wird. |

||||

@ -1,193 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erkunden Sie FastSAM, eine CNN-basierte Lösung zur Echtzeit-Segmentierung von Objekten in Bildern. Verbesserte Benutzerinteraktion, Recheneffizienz und anpassbar für verschiedene Vision-Aufgaben. |

||||

keywords: FastSAM, maschinelles Lernen, CNN-basierte Lösung, Objektsegmentierung, Echtzeillösung, Ultralytics, Vision-Aufgaben, Bildverarbeitung, industrielle Anwendungen, Benutzerinteraktion |

||||

--- |

||||

|

||||

# Fast Segment Anything Model (FastSAM) |

||||

|

||||

Das Fast Segment Anything Model (FastSAM) ist eine neuartige, Echtzeit-CNN-basierte Lösung für die Segment Anything Aufgabe. Diese Aufgabe zielt darauf ab, jedes Objekt in einem Bild auf Basis verschiedener möglicher Benutzerinteraktionen zu segmentieren. FastSAM reduziert signifikant den Rechenbedarf, während es eine wettbewerbsfähige Leistung beibehält und somit für eine Vielzahl von Vision-Aufgaben praktisch einsetzbar ist. |

||||

|

||||

|

||||

|

||||

## Überblick |

||||

|

||||

FastSAM wurde entwickelt, um die Einschränkungen des [Segment Anything Model (SAM)](sam.md) zu beheben, einem schweren Transformer-Modell mit erheblichem Rechenressourcenbedarf. Das FastSAM teilt die Segment Anything Aufgabe in zwei aufeinanderfolgende Stufen auf: die Instanzsegmentierung und die promptgesteuerte Auswahl. In der ersten Stufe wird [YOLOv8-seg](../tasks/segment.md) verwendet, um die Segmentierungsmasken aller Instanzen im Bild zu erzeugen. In der zweiten Stufe gibt es den Bereich von Interesse aus, der dem Prompt entspricht. |

||||

|

||||

## Hauptmerkmale |

||||

|

||||

1. **Echtzeitlösung:** Durch die Nutzung der Recheneffizienz von CNNs bietet FastSAM eine Echtzeitlösung für die Segment Anything Aufgabe und eignet sich somit für industrielle Anwendungen, die schnelle Ergebnisse erfordern. |

||||

|

||||

2. **Effizienz und Leistung:** FastSAM bietet eine signifikante Reduzierung des Rechen- und Ressourcenbedarfs, ohne die Leistungsqualität zu beeinträchtigen. Es erzielt eine vergleichbare Leistung wie SAM, verwendet jedoch drastisch reduzierte Rechenressourcen und ermöglicht so eine Echtzeitanwendung. |

||||

|

||||

3. **Promptgesteuerte Segmentierung:** FastSAM kann jedes Objekt in einem Bild anhand verschiedener möglicher Benutzerinteraktionsaufforderungen segmentieren. Dies ermöglicht Flexibilität und Anpassungsfähigkeit in verschiedenen Szenarien. |

||||

|

||||

4. **Basierend auf YOLOv8-seg:** FastSAM basiert auf [YOLOv8-seg](../tasks/segment.md), einem Objektdetektor mit einem Instanzsegmentierungsmodul. Dadurch ist es in der Lage, die Segmentierungsmasken aller Instanzen in einem Bild effektiv zu erzeugen. |

||||

|

||||

5. **Wettbewerbsfähige Ergebnisse auf Benchmarks:** Bei der Objektvorschlagsaufgabe auf MS COCO erzielt FastSAM hohe Punktzahlen bei deutlich schnellerem Tempo als [SAM](sam.md) auf einer einzelnen NVIDIA RTX 3090. Dies demonstriert seine Effizienz und Leistungsfähigkeit. |

||||

|

||||

6. **Praktische Anwendungen:** Der vorgeschlagene Ansatz bietet eine neue, praktische Lösung für eine Vielzahl von Vision-Aufgaben mit sehr hoher Geschwindigkeit, die zehn- oder hundertmal schneller ist als vorhandene Methoden. |

||||

|

||||

7. **Möglichkeit zur Modellkompression:** FastSAM zeigt, dass der Rechenaufwand erheblich reduziert werden kann, indem ein künstlicher Prior in die Struktur eingeführt wird. Dadurch eröffnen sich neue Möglichkeiten für große Modellarchitekturen für allgemeine Vision-Aufgaben. |

||||

|

||||

## Verfügbare Modelle, unterstützte Aufgaben und Betriebsmodi |

||||

|

||||

In dieser Tabelle werden die verfügbaren Modelle mit ihren spezifischen vorab trainierten Gewichten, den unterstützten Aufgaben und ihrer Kompatibilität mit verschiedenen Betriebsmodi wie [Inferenz](../modes/predict.md), [Validierung](../modes/val.md), [Training](../modes/train.md) und [Export](../modes/export.md) angezeigt. Dabei stehen ✅ Emojis für unterstützte Modi und ❌ Emojis für nicht unterstützte Modi. |

||||

|

||||

| Modelltyp | Vorab trainierte Gewichte | Unterstützte Aufgaben | Inferenz | Validierung | Training | Export | |

||||

|-----------|---------------------------|---------------------------------------------|----------|-------------|----------|--------| |

||||

| FastSAM-s | `FastSAM-s.pt` | [Instanzsegmentierung](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ | |

||||

| FastSAM-x | `FastSAM-x.pt` | [Instanzsegmentierung](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ | |

||||

|

||||

## Beispiele für die Verwendung |

||||

|

||||

Die FastSAM-Modelle lassen sich problemlos in Ihre Python-Anwendungen integrieren. Ultralytics bietet eine benutzerfreundliche Python-API und CLI-Befehle zur Vereinfachung der Entwicklung. |

||||

|

||||

### Verwendung der Methode `predict` |

||||

|

||||

Um eine Objekterkennung auf einem Bild durchzuführen, verwenden Sie die Methode `predict` wie folgt: |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics import FastSAM |

||||

from ultralytics.models.fastsam import FastSAMPrompt |

||||

|

||||

# Definieren Sie die Quelle für die Inferenz |

||||

source = 'Pfad/zum/bus.jpg' |

||||

|

||||

# Erstellen Sie ein FastSAM-Modell |

||||

model = FastSAM('FastSAM-s.pt') # oder FastSAM-x.pt |

||||

|

||||

# Führen Sie die Inferenz auf einem Bild durch |

||||

everything_results = model(source, device='cpu', retina_masks=True, imgsz=1024, conf=0.4, iou=0.9) |

||||

|

||||

# Bereiten Sie ein Prompt-Process-Objekt vor |

||||

prompt_process = FastSAMPrompt(source, everything_results, device='cpu') |

||||

|

||||

# Alles-Prompt |

||||

ann = prompt_process.everything_prompt() |

||||

|

||||

# Bbox Standardform [0,0,0,0] -> [x1,y1,x2,y2] |

||||

ann = prompt_process.box_prompt(bbox=[200, 200, 300, 300]) |

||||

|

||||

# Text-Prompt |

||||

ann = prompt_process.text_prompt(text='ein Foto von einem Hund') |

||||

|

||||

# Punkt-Prompt |

||||

# Punkte Standard [[0,0]] [[x1,y1],[x2,y2]] |

||||

# Punktbezeichnung Standard [0] [1,0] 0:Hintergrund, 1:Vordergrund |

||||

ann = prompt_process.point_prompt(points=[[200, 200]], pointlabel=[1]) |

||||

prompt_process.plot(annotations=ann, output='./') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

```bash |

||||

# Laden Sie ein FastSAM-Modell und segmentieren Sie alles damit |

||||

yolo segment predict model=FastSAM-s.pt source=Pfad/zum/bus.jpg imgsz=640 |

||||

``` |

||||

|

||||

Dieser Code-Ausschnitt zeigt die Einfachheit des Ladens eines vorab trainierten Modells und das Durchführen einer Vorhersage auf einem Bild. |

||||

|

||||

### Verwendung von `val` |

||||

|

||||

Die Validierung des Modells auf einem Datensatz kann wie folgt durchgeführt werden: |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics import FastSAM |

||||

|

||||

# Erstellen Sie ein FastSAM-Modell |

||||

model = FastSAM('FastSAM-s.pt') # oder FastSAM-x.pt |

||||

|

||||

# Validieren Sie das Modell |

||||

results = model.val(data='coco8-seg.yaml') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

```bash |

||||

# Laden Sie ein FastSAM-Modell und validieren Sie es auf dem COCO8-Beispieldatensatz mit Bildgröße 640 |

||||

yolo segment val model=FastSAM-s.pt data=coco8.yaml imgsz=640 |

||||

``` |

||||

|

||||

Bitte beachten Sie, dass FastSAM nur die Erkennung und Segmentierung einer einzigen Objektklasse unterstützt. Das bedeutet, dass es alle Objekte als dieselbe Klasse erkennt und segmentiert. Daher müssen Sie beim Vorbereiten des Datensatzes alle Objektkategorie-IDs in 0 umwandeln. |

||||

|

||||

## Offizielle Verwendung von FastSAM |

||||

|

||||

FastSAM ist auch direkt aus dem [https://github.com/CASIA-IVA-Lab/FastSAM](https://github.com/CASIA-IVA-Lab/FastSAM) Repository erhältlich. Hier ist ein kurzer Überblick über die typischen Schritte, die Sie unternehmen könnten, um FastSAM zu verwenden: |

||||

|

||||

### Installation |

||||

|

||||

1. Klonen Sie das FastSAM-Repository: |

||||

```shell |

||||

git clone https://github.com/CASIA-IVA-Lab/FastSAM.git |

||||

``` |

||||

|

||||

2. Erstellen und aktivieren Sie eine Conda-Umgebung mit Python 3.9: |

||||

```shell |

||||

conda create -n FastSAM python=3.9 |

||||

conda activate FastSAM |

||||

``` |

||||

|

||||

3. Navigieren Sie zum geklonten Repository und installieren Sie die erforderlichen Pakete: |

||||

```shell |

||||

cd FastSAM |

||||

pip install -r requirements.txt |

||||

``` |

||||

|

||||

4. Installieren Sie das CLIP-Modell: |

||||

```shell |

||||

pip install git+https://github.com/openai/CLIP.git |

||||

``` |

||||

|

||||

### Beispielverwendung |

||||

|

||||

1. Laden Sie eine [Modell-Sicherung](https://drive.google.com/file/d/1m1sjY4ihXBU1fZXdQ-Xdj-mDltW-2Rqv/view?usp=sharing) herunter. |

||||

|

||||

2. Verwenden Sie FastSAM für Inferenz. Beispielbefehle: |

||||

|

||||

- Segmentieren Sie alles in einem Bild: |

||||

```shell |

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg |

||||

``` |

||||

|

||||

- Segmentieren Sie bestimmte Objekte anhand eines Textprompts: |

||||

```shell |

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --text_prompt "der gelbe Hund" |

||||

``` |

||||

|

||||

- Segmentieren Sie Objekte innerhalb eines Begrenzungsrahmens (geben Sie die Boxkoordinaten im xywh-Format an): |

||||

```shell |

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --box_prompt "[570,200,230,400]" |

||||

``` |

||||

|

||||

- Segmentieren Sie Objekte in der Nähe bestimmter Punkte: |

||||

```shell |

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --point_prompt "[[520,360],[620,300]]" --point_label "[1,0]" |

||||

``` |

||||

|

||||

Sie können FastSAM auch über eine [Colab-Demo](https://colab.research.google.com/drive/1oX14f6IneGGw612WgVlAiy91UHwFAvr9?usp=sharing) oder die [HuggingFace-Web-Demo](https://huggingface.co/spaces/An-619/FastSAM) testen, um eine visuelle Erfahrung zu machen. |

||||

|

||||

## Zitate und Danksagungen |

||||

|

||||

Wir möchten den Autoren von FastSAM für ihre bedeutenden Beiträge auf dem Gebiet der Echtzeit-Instanzsegmentierung danken: |

||||

|

||||

!!! Quote "" |

||||

|

||||

=== "BibTeX" |

||||

|

||||

```bibtex |

||||

@misc{zhao2023fast, |

||||

title={Fast Segment Anything}, |

||||

author={Xu Zhao and Wenchao Ding and Yongqi An and Yinglong Du and Tao Yu and Min Li and Ming Tang and Jinqiao Wang}, |

||||

year={2023}, |

||||

eprint={2306.12156}, |

||||

archivePrefix={arXiv}, |

||||

primaryClass={cs.CV} |

||||

} |

||||

``` |

||||

|

||||

Die ursprüngliche FastSAM-Arbeit ist auf [arXiv](https://arxiv.org/abs/2306.12156) zu finden. Die Autoren haben ihre Arbeit öffentlich zugänglich gemacht, und der Code ist auf [GitHub](https://github.com/CASIA-IVA-Lab/FastSAM) verfügbar. Wir schätzen ihre Bemühungen, das Fachgebiet voranzutreiben und ihre Arbeit der breiteren Gemeinschaft zugänglich zu machen. |

||||

@ -1,98 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Entdecken Sie die vielfältige Palette an Modellen der YOLO-Familie, SAM, MobileSAM, FastSAM, YOLO-NAS und RT-DETR, die von Ultralytics unterstützt werden. Beginnen Sie mit Beispielen für die CLI- und Python-Nutzung. |

||||

keywords: Ultralytics, Dokumentation, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, Modelle, Architekturen, Python, CLI |

||||

--- |

||||

|

||||

# Von Ultralytics unterstützte Modelle |

||||

|

||||

Willkommen bei der Modell-Dokumentation von Ultralytics! Wir bieten Unterstützung für eine breite Palette von Modellen, die jeweils für spezifische Aufgaben wie [Objekterkennung](../tasks/detect.md), [Instanzsegmentierung](../tasks/segment.md), [Bildklassifizierung](../tasks/classify.md), [Posenschätzung](../tasks/pose.md) und [Multi-Objekt-Tracking](../modes/track.md) maßgeschneidert sind. Wenn Sie daran interessiert sind, Ihre Modellarchitektur bei Ultralytics beizutragen, sehen Sie sich unseren [Beitragenden-Leitfaden](../../help/contributing.md) an. |

||||

|

||||

!!! Note "Hinweis" |

||||

|

||||

🚧 Unsere Dokumentation in verschiedenen Sprachen ist derzeit im Aufbau und wir arbeiten hart daran, sie zu verbessern. Vielen Dank für Ihre Geduld! 🙏 |

||||

|

||||

## Vorgestellte Modelle |

||||

|

||||

Hier sind einige der wichtigsten unterstützten Modelle: |

||||

|

||||

1. **[YOLOv3](yolov3.md)**: Die dritte Iteration der YOLO-Modellfamilie, ursprünglich von Joseph Redmon, bekannt für ihre effiziente Echtzeit-Objekterkennungsfähigkeiten. |

||||

2. **[YOLOv4](yolov4.md)**: Ein dunkelnetz-natives Update von YOLOv3, veröffentlicht von Alexey Bochkovskiy im Jahr 2020. |

||||

3. **[YOLOv5](yolov5.md)**: Eine verbesserte Version der YOLO-Architektur von Ultralytics, die bessere Leistungs- und Geschwindigkeitskompromisse im Vergleich zu früheren Versionen bietet. |

||||

4. **[YOLOv6](yolov6.md)**: Veröffentlicht von [Meituan](https://about.meituan.com/) im Jahr 2022 und in vielen autonomen Lieferrobotern des Unternehmens im Einsatz. |

||||

5. **[YOLOv7](yolov7.md)**: Aktualisierte YOLO-Modelle, die 2022 von den Autoren von YOLOv4 veröffentlicht wurden. |

||||

6. **[YOLOv8](yolov8.md) NEU 🚀**: Die neueste Version der YOLO-Familie, mit erweiterten Fähigkeiten wie Instanzsegmentierung, Pose/Schlüsselpunktschätzung und Klassifizierung. |

||||

7. **[Segment Anything Model (SAM)](sam.md)**: Metas Segment Anything Model (SAM). |

||||

8. **[Mobile Segment Anything Model (MobileSAM)](mobile-sam.md)**: MobileSAM für mobile Anwendungen, von der Kyung Hee University. |

||||

9. **[Fast Segment Anything Model (FastSAM)](fast-sam.md)**: FastSAM von der Image & Video Analysis Group, Institute of Automation, Chinesische Akademie der Wissenschaften. |

||||

10. **[YOLO-NAS](yolo-nas.md)**: YOLO Neural Architecture Search (NAS) Modelle. |

||||

11. **[Realtime Detection Transformers (RT-DETR)](rtdetr.md)**: Baidus PaddlePaddle Realtime Detection Transformer (RT-DETR) Modelle. |

||||

|

||||

<p align="center"> |

||||

<br> |

||||

<iframe width="720" height="405" src="https://www.youtube.com/embed/MWq1UxqTClU?si=nHAW-lYDzrz68jR0" |

||||

title="YouTube-Video-Player" frameborder="0" |

||||

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" |

||||

allowfullscreen> |

||||

</iframe> |

||||

<br> |

||||

<strong>Anschauen:</strong> Führen Sie Ultralytics YOLO-Modelle in nur wenigen Codezeilen aus. |

||||

</p> |

||||

|

||||

## Einstieg: Nutzungbeispiele |

||||

|

||||

Dieses Beispiel bietet einfache YOLO-Trainings- und Inferenzbeispiele. Für vollständige Dokumentationen über diese und andere [Modi](../modes/index.md) siehe die Dokumentationsseiten [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) und [Export](../modes/export.md). |

||||

|

||||

Beachten Sie, dass das folgende Beispiel für YOLOv8 [Detect](../tasks/detect.md) Modelle zur Objekterkennung ist. Für zusätzliche unterstützte Aufgaben siehe die Dokumentation zu [Segment](../tasks/segment.md), [Classify](../tasks/classify.md) und [Pose](../tasks/pose.md). |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

|

||||

Vorgefertigte PyTorch `*.pt` Modelle sowie Konfigurationsdateien `*.yaml` können den Klassen `YOLO()`, `SAM()`, `NAS()` und `RTDETR()` übergeben werden, um eine Modellinstanz in Python zu erstellen: |

||||

|

||||

```python |

||||

from ultralytics import YOLO |

||||

|

||||

# Laden eines COCO-vortrainierten YOLOv8n Modells |

||||

model = YOLO('yolov8n.pt') |

||||

|

||||

# Modellinformationen anzeigen (optional) |

||||

model.info() |

||||

|

||||

# Model auf dem COCO8-Beispieldatensatz für 100 Epochen trainieren |

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640) |

||||

|

||||

# Inferenz mit dem YOLOv8n Modell auf das Bild 'bus.jpg' ausführen |

||||

results = model('path/to/bus.jpg') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

|

||||

CLI-Befehle sind verfügbar, um die Modelle direkt auszuführen: |

||||

|

||||

```bash |

||||

# Ein COCO-vortrainiertes YOLOv8n Modell laden und auf dem COCO8-Beispieldatensatz für 100 Epochen trainieren |

||||

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640 |

||||

|

||||

# Ein COCO-vortrainiertes YOLOv8n Modell laden und Inferenz auf das Bild 'bus.jpg' ausführen |

||||

yolo predict model=yolov8n.pt source=path/to/bus.jpg |

||||

``` |

||||

|

||||

## Neue Modelle beitragen |

||||

|

||||

Sind Sie daran interessiert, Ihr Modell bei Ultralytics beizutragen? Großartig! Wir sind immer offen dafür, unser Modellportfolio zu erweitern. |

||||

|

||||

1. **Repository forken**: Beginnen Sie mit dem Forken des [Ultralytics GitHub-Repositorys](https://github.com/ultralytics/ultralytics). |

||||

|

||||

2. **Ihren Fork klonen**: Klonen Sie Ihren Fork auf Ihre lokale Maschine und erstellen Sie einen neuen Branch, um daran zu arbeiten. |

||||

|

||||

3. **Ihr Modell implementieren**: Fügen Sie Ihr Modell entsprechend den in unserem [Beitragenden-Leitfaden](../../help/contributing.md) bereitgestellten Kodierungsstandards und Richtlinien hinzu. |

||||

|

||||

4. **Gründlich testen**: Stellen Sie sicher, dass Sie Ihr Modell sowohl isoliert als auch als Teil des Pipelines gründlich testen. |

||||

|

||||

5. **Eine Pull-Anfrage erstellen**: Sobald Sie mit Ihrem Modell zufrieden sind, erstellen Sie eine Pull-Anfrage zum Hauptrepository zur Überprüfung. |

||||

|

||||

6. **Code-Review & Zusammenführen**: Nach der Überprüfung, wenn Ihr Modell unseren Kriterien entspricht, wird es in das Hauptrepository zusammengeführt. |

||||

|

||||

Für detaillierte Schritte konsultieren Sie unseren [Beitragenden-Leitfaden](../../help/contributing.md). |

||||

@ -1,116 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erfahren Sie mehr über MobileSAM, dessen Implementierung, den Vergleich mit dem Original-SAM und wie Sie es im Ultralytics-Framework herunterladen und testen können. Verbessern Sie Ihre mobilen Anwendungen heute. |

||||

keywords: MobileSAM, Ultralytics, SAM, mobile Anwendungen, Arxiv, GPU, API, Bildencoder, Maskendekoder, Modell-Download, Testmethode |

||||

--- |

||||

|

||||

|

||||

|

||||

# Mobile Segment Anything (MobileSAM) |

||||

|

||||

Das MobileSAM-Paper ist jetzt auf [arXiv](https://arxiv.org/pdf/2306.14289.pdf) verfügbar. |

||||

|

||||

Eine Demonstration von MobileSAM, das auf einer CPU ausgeführt wird, finden Sie unter diesem [Demo-Link](https://huggingface.co/spaces/dhkim2810/MobileSAM). Die Leistung auf einer Mac i5 CPU beträgt etwa 3 Sekunden. Auf der Hugging Face-Demo führt die Benutzeroberfläche und CPUs mit niedrigerer Leistung zu einer langsameren Reaktion, aber die Funktion bleibt effektiv. |

||||

|

||||

MobileSAM ist in verschiedenen Projekten implementiert, darunter [Grounding-SAM](https://github.com/IDEA-Research/Grounded-Segment-Anything), [AnyLabeling](https://github.com/vietanhdev/anylabeling) und [Segment Anything in 3D](https://github.com/Jumpat/SegmentAnythingin3D). |

||||

|

||||

MobileSAM wird mit einem einzigen GPU und einem 100K-Datensatz (1% der Originalbilder) in weniger als einem Tag trainiert. Der Code für dieses Training wird in Zukunft verfügbar gemacht. |

||||

|

||||

## Verfügbarkeit von Modellen, unterstützte Aufgaben und Betriebsarten |

||||

|

||||

Die folgende Tabelle zeigt die verfügbaren Modelle mit ihren spezifischen vortrainierten Gewichten, die unterstützten Aufgaben und ihre Kompatibilität mit unterschiedlichen Betriebsarten wie [Inferenz](../modes/predict.md), [Validierung](../modes/val.md), [Training](../modes/train.md) und [Export](../modes/export.md). Unterstützte Betriebsarten werden mit ✅-Emojis und nicht unterstützte Betriebsarten mit ❌-Emojis angezeigt. |

||||

|

||||

| Modelltyp | Vortrainierte Gewichte | Unterstützte Aufgaben | Inferenz | Validierung | Training | Export | |

||||

|-----------|------------------------|---------------------------------------------|----------|-------------|----------|--------| |

||||

| MobileSAM | `mobile_sam.pt` | [Instanzsegmentierung](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ | |

||||

|

||||

## Anpassung von SAM zu MobileSAM |

||||

|

||||

Da MobileSAM die gleiche Pipeline wie das Original-SAM beibehält, haben wir das ursprüngliche Preprocessing, Postprocessing und alle anderen Schnittstellen eingebunden. Personen, die derzeit das ursprüngliche SAM verwenden, können daher mit minimalem Aufwand zu MobileSAM wechseln. |

||||

|

||||

MobileSAM bietet vergleichbare Leistungen wie das ursprüngliche SAM und behält dieselbe Pipeline, mit Ausnahme eines Wechsels des Bildencoders. Konkret ersetzen wir den ursprünglichen, leistungsstarken ViT-H-Encoder (632M) durch einen kleineren Tiny-ViT-Encoder (5M). Auf einem einzelnen GPU arbeitet MobileSAM in etwa 12 ms pro Bild: 8 ms auf dem Bildencoder und 4 ms auf dem Maskendekoder. |

||||

|

||||

Die folgende Tabelle bietet einen Vergleich der Bildencoder, die auf ViT basieren: |

||||

|

||||

| Bildencoder | Original-SAM | MobileSAM | |

||||

|-----------------|--------------|-----------| |

||||

| Parameter | 611M | 5M | |

||||

| Geschwindigkeit | 452ms | 8ms | |

||||

|

||||

Sowohl das ursprüngliche SAM als auch MobileSAM verwenden denselben promptgeführten Maskendekoder: |

||||

|

||||

| Maskendekoder | Original-SAM | MobileSAM | |

||||

|-----------------|--------------|-----------| |

||||

| Parameter | 3.876M | 3.876M | |

||||

| Geschwindigkeit | 4ms | 4ms | |

||||

|

||||

Hier ist ein Vergleich der gesamten Pipeline: |

||||

|

||||

| Gesamte Pipeline (Enc+Dec) | Original-SAM | MobileSAM | |

||||

|----------------------------|--------------|-----------| |

||||

| Parameter | 615M | 9.66M | |

||||

| Geschwindigkeit | 456ms | 12ms | |

||||

|

||||

Die Leistung von MobileSAM und des ursprünglichen SAM werden sowohl mit einem Punkt als auch mit einem Kasten als Prompt demonstriert. |

||||

|

||||

|

||||

|

||||

|

||||

|

||||

Mit seiner überlegenen Leistung ist MobileSAM etwa 5-mal kleiner und 7-mal schneller als das aktuelle FastSAM. Weitere Details finden Sie auf der [MobileSAM-Projektseite](https://github.com/ChaoningZhang/MobileSAM). |

||||

|

||||

## Testen von MobileSAM in Ultralytics |

||||

|

||||

Wie beim ursprünglichen SAM bieten wir eine unkomplizierte Testmethode in Ultralytics an, einschließlich Modi für Punkt- und Kasten-Prompts. |

||||

|

||||

### Modell-Download |

||||

|

||||

Sie können das Modell [hier](https://github.com/ChaoningZhang/MobileSAM/blob/master/weights/mobile_sam.pt) herunterladen. |

||||

|

||||

### Punkt-Prompt |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics import SAM |

||||

|

||||

# Laden Sie das Modell |

||||

model = SAM('mobile_sam.pt') |

||||

|

||||

# Vorhersage einer Segmentierung basierend auf einem Punkt-Prompt |

||||

model.predict('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1]) |

||||

``` |

||||

|

||||

### Kasten-Prompt |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics import SAM |

||||

|

||||

# Laden Sie das Modell |

||||

model = SAM('mobile_sam.pt') |

||||

|

||||

# Vorhersage einer Segmentierung basierend auf einem Kasten-Prompt |

||||

model.predict('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709]) |

||||

``` |

||||

|

||||

Wir haben `MobileSAM` und `SAM` mit derselben API implementiert. Für weitere Verwendungsinformationen sehen Sie bitte die [SAM-Seite](sam.md). |

||||

|

||||

## Zitate und Danksagungen |

||||

|

||||

Wenn Sie MobileSAM in Ihrer Forschungs- oder Entwicklungsarbeit nützlich finden, zitieren Sie bitte unser Paper: |

||||

|

||||

!!! Quote "" |

||||

|

||||

=== "BibTeX" |

||||

|

||||

```bibtex |

||||

@article{mobile_sam, |

||||

title={Faster Segment Anything: Towards Lightweight SAM for Mobile Applications}, |

||||

author={Zhang, Chaoning and Han, Dongshen and Qiao, Yu and Kim, Jung Uk and Bae, Sung Ho and Lee, Seungkyu and Hong, Choong Seon}, |

||||

journal={arXiv preprint arXiv:2306.14289}, |

||||

year={2023} |

||||

} |

||||

@ -1,93 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Entdecken Sie die Funktionen und Vorteile von RT-DETR, dem effizienten und anpassungsfähigen Echtzeitobjektdetektor von Baidu, der von Vision Transformers unterstützt wird, einschließlich vortrainierter Modelle. |

||||

keywords: RT-DETR, Baidu, Vision Transformers, Objekterkennung, Echtzeitleistung, CUDA, TensorRT, IoU-bewusste Query-Auswahl, Ultralytics, Python API, PaddlePaddle |

||||

--- |

||||

|

||||

# Baidus RT-DETR: Ein Echtzeit-Objektdetektor auf Basis von Vision Transformers |

||||

|

||||

## Überblick |

||||

|

||||

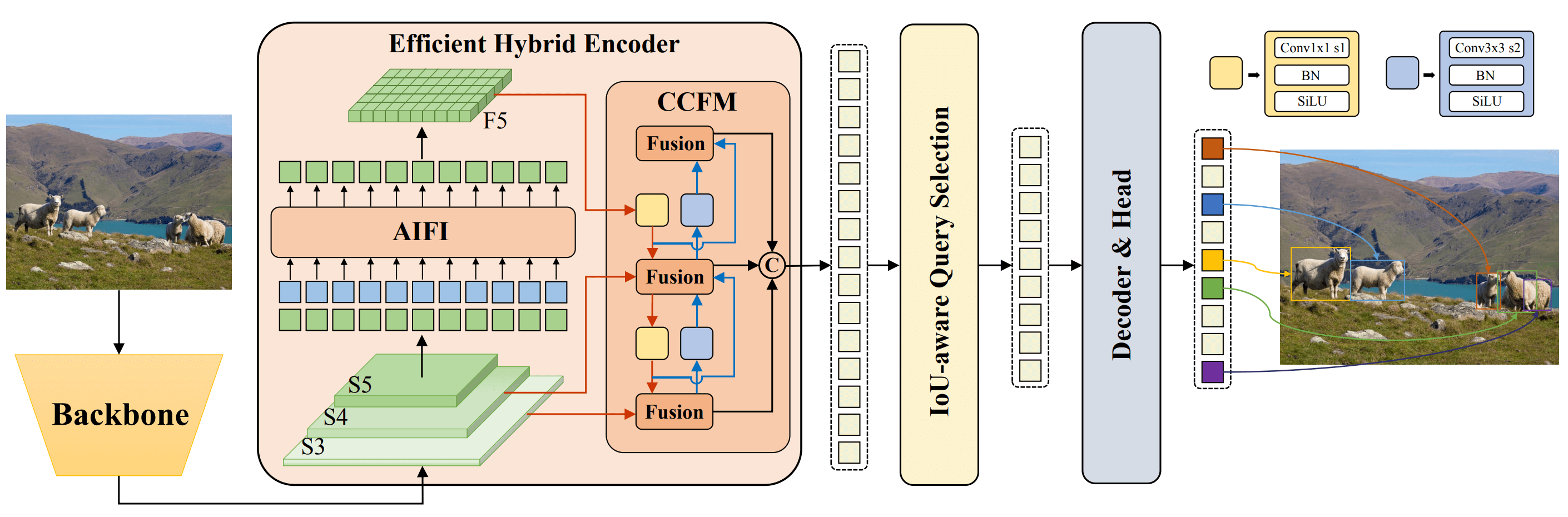

Der Real-Time Detection Transformer (RT-DETR), entwickelt von Baidu, ist ein moderner End-to-End-Objektdetektor, der Echtzeitleistung mit hoher Genauigkeit bietet. Er nutzt die Leistung von Vision Transformers (ViT), um Multiskalen-Funktionen effizient zu verarbeiten, indem intra-skaliere Interaktion und eine skalenübergreifende Fusion entkoppelt werden. RT-DETR ist hoch anpassungsfähig und unterstützt flexible Anpassung der Inferenzgeschwindigkeit durch Verwendung verschiedener Decoder-Schichten ohne erneutes Training. Das Modell übertrifft viele andere Echtzeit-Objektdetektoren auf beschleunigten Backends wie CUDA mit TensorRT. |

||||

|

||||

|

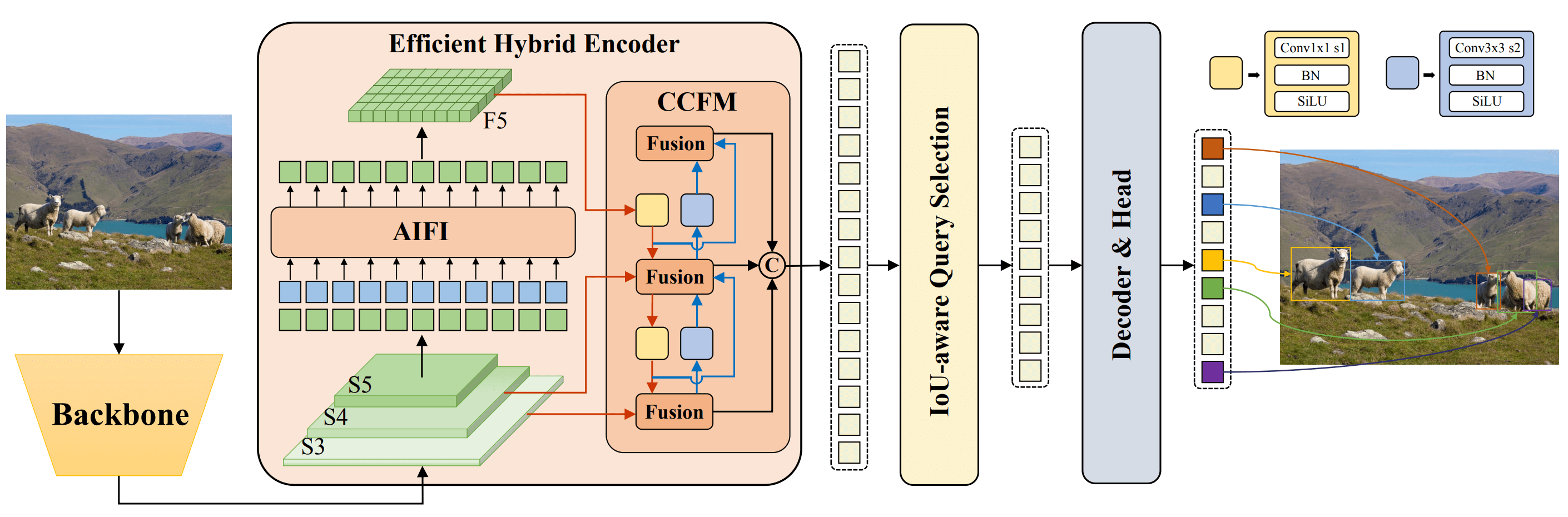

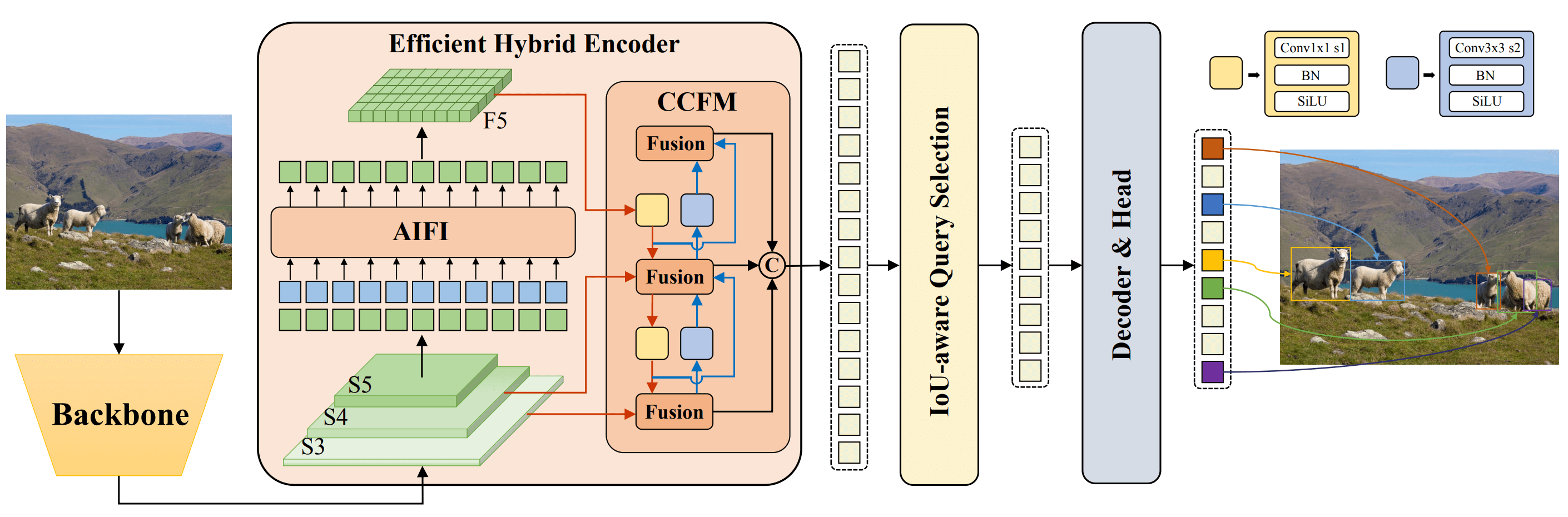

||||

**Übersicht von Baidus RT-DETR.** Die Modellarchitekturdiagramm des RT-DETR zeigt die letzten drei Stufen des Backbone {S3, S4, S5} als Eingabe für den Encoder. Der effiziente Hybrid-Encoder verwandelt Multiskalen-Funktionen durch intraskalare Feature-Interaktion (AIFI) und das skalenübergreifende Feature-Fusion-Modul (CCFM) in eine Sequenz von Bildmerkmalen. Die IoU-bewusste Query-Auswahl wird verwendet, um eine feste Anzahl von Bildmerkmalen als anfängliche Objekt-Queries für den Decoder auszuwählen. Der Decoder optimiert iterativ Objekt-Queries, um Boxen und Vertrauenswerte zu generieren ([Quelle](https://arxiv.org/pdf/2304.08069.pdf)). |

||||

|

||||

### Hauptmerkmale |

||||

|

||||

- **Effizienter Hybrid-Encoder:** Baidus RT-DETR verwendet einen effizienten Hybrid-Encoder, der Multiskalen-Funktionen verarbeitet, indem intra-skaliere Interaktion und eine skalenübergreifende Fusion entkoppelt werden. Dieses einzigartige Design auf Basis von Vision Transformers reduziert die Rechenkosten und ermöglicht die Echtzeit-Objekterkennung. |

||||

- **IoU-bewusste Query-Auswahl:** Baidus RT-DETR verbessert die Initialisierung von Objekt-Queries, indem IoU-bewusste Query-Auswahl verwendet wird. Dadurch kann das Modell sich auf die relevantesten Objekte in der Szene konzentrieren und die Erkennungsgenauigkeit verbessern. |

||||

- **Anpassbare Inferenzgeschwindigkeit:** Baidus RT-DETR ermöglicht flexible Anpassungen der Inferenzgeschwindigkeit durch Verwendung unterschiedlicher Decoder-Schichten ohne erneutes Training. Diese Anpassungsfähigkeit erleichtert den praktischen Einsatz in verschiedenen Echtzeit-Objekterkennungsszenarien. |

||||

|

||||

## Vortrainierte Modelle |

||||

|

||||

Die Ultralytics Python API bietet vortrainierte PaddlePaddle RT-DETR-Modelle in verschiedenen Skalierungen: |

||||

|

||||

- RT-DETR-L: 53,0% AP auf COCO val2017, 114 FPS auf T4 GPU |

||||

- RT-DETR-X: 54,8% AP auf COCO val2017, 74 FPS auf T4 GPU |

||||

|

||||

## Beispiele für die Verwendung |

||||

|

||||

Das folgende Beispiel enthält einfache Trainings- und Inferenzbeispiele für RT-DETRR. Für die vollständige Dokumentation zu diesen und anderen [Modi](../modes/index.md) siehe die Dokumentationsseiten für [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) und [Export](../modes/export.md). |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

|

||||

```python |

||||

from ultralytics import RTDETR |

||||

|

||||

# Laden Sie ein vortrainiertes RT-DETR-l Modell auf COCO |

||||

model = RTDETR('rtdetr-l.pt') |

||||

|

||||

# Zeigen Sie Informationen über das Modell an (optional) |

||||

model.info() |

||||

|

||||

# Trainieren Sie das Modell auf dem COCO8-Beispiel-Datensatz für 100 Epochen |

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640) |

||||

|

||||

# Führen Sie die Inferenz mit dem RT-DETR-l Modell auf dem Bild 'bus.jpg' aus |

||||

results = model('path/to/bus.jpg') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

|

||||

```bash |

||||

# Laden Sie ein vortrainiertes RT-DETR-l Modell auf COCO und trainieren Sie es auf dem COCO8-Beispiel-Datensatz für 100 Epochen |

||||

yolo train model=rtdetr-l.pt data=coco8.yaml epochs=100 imgsz=640 |

||||

|

||||

# Laden Sie ein vortrainiertes RT-DETR-l Modell auf COCO und führen Sie die Inferenz auf dem Bild 'bus.jpg' aus |

||||

yolo predict model=rtdetr-l.pt source=path/to/bus.jpg |

||||

``` |

||||

|

||||

## Unterstützte Aufgaben und Modi |

||||

|

||||

In dieser Tabelle werden die Modelltypen, die spezifischen vortrainierten Gewichte, die von jedem Modell unterstützten Aufgaben und die verschiedenen Modi ([Train](../modes/train.md), [Val](../modes/val.md), [Predict](../modes/predict.md), [Export](../modes/export.md)), die unterstützt werden, mit ✅-Emoji angezeigt. |

||||

|

||||

| Modelltyp | Vortrainierte Gewichte | Unterstützte Aufgaben | Inferenz | Validierung | Training | Exportieren | |

||||

|--------------------|------------------------|---------------------------------------|----------|-------------|----------|-------------| |

||||

| RT-DETR Groß | `rtdetr-l.pt` | [Objekterkennung](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ | |

||||

| RT-DETR Extra-Groß | `rtdetr-x.pt` | [Objekterkennung](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ | |

||||

|

||||

## Zitate und Danksagungen |

||||

|

||||

Wenn Sie Baidus RT-DETR in Ihrer Forschungs- oder Entwicklungsarbeit verwenden, zitieren Sie bitte das [ursprüngliche Papier](https://arxiv.org/abs/2304.08069): |

||||

|

||||

!!! Quote "" |

||||

|

||||

=== "BibTeX" |

||||

|

||||

```bibtex |

||||

@misc{lv2023detrs, |

||||

title={DETRs Beat YOLOs on Real-time Object Detection}, |

||||

author={Wenyu Lv and Shangliang Xu and Yian Zhao and Guanzhong Wang and Jinman Wei and Cheng Cui and Yuning Du and Qingqing Dang and Yi Liu}, |

||||

year={2023}, |

||||

eprint={2304.08069}, |

||||

archivePrefix={arXiv}, |

||||

primaryClass={cs.CV} |

||||

} |

||||

``` |

||||

|

||||

Wir möchten Baidu und dem [PaddlePaddle](https://github.com/PaddlePaddle/PaddleDetection)-Team für die Erstellung und Pflege dieser wertvollen Ressource für die Computer-Vision-Community danken. Ihre Beitrag zum Gebiet der Entwicklung des Echtzeit-Objekterkenners auf Basis von Vision Transformers, RT-DETR, wird sehr geschätzt. |

||||

|

||||

*Keywords: RT-DETR, Transformer, ViT, Vision Transformers, Baidu RT-DETR, PaddlePaddle, Paddle Paddle RT-DETR, Objekterkennung in Echtzeit, objekterkennung basierend auf Vision Transformers, vortrainierte PaddlePaddle RT-DETR Modelle, Verwendung von Baidus RT-DETR, Ultralytics Python API* |

||||

@ -1,226 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erkunden Sie das innovative Segment Anything Model (SAM) von Ultralytics, das Echtzeit-Bildsegmentierung ermöglicht. Erfahren Sie mehr über die promptable Segmentierung, die Zero-Shot-Performance und die Anwendung. |

||||

keywords: Ultralytics, Bildsegmentierung, Segment Anything Model, SAM, SA-1B-Datensatz, Echtzeit-Performance, Zero-Shot-Transfer, Objekterkennung, Bildanalyse, maschinelles Lernen |

||||

--- |

||||

|

||||

# Segment Anything Model (SAM) |

||||

|

||||

Willkommen an der Spitze der Bildsegmentierung mit dem Segment Anything Model (SAM). Dieses revolutionäre Modell hat mit promptabler Bildsegmentierung und Echtzeit-Performance neue Standards in diesem Bereich gesetzt. |

||||

|

||||

## Einführung in SAM: Das Segment Anything Model |

||||

|

||||

Das Segment Anything Model (SAM) ist ein innovatives Bildsegmentierungsmodell, das promptable Segmentierung ermöglicht und so eine beispiellose Vielseitigkeit bei der Bildanalyse bietet. SAM bildet das Herzstück der Segment Anything Initiative, einem bahnbrechenden Projekt, das ein neuartiges Modell, eine neue Aufgabe und einen neuen Datensatz für die Bildsegmentierung einführt. |

||||

|

||||

Dank seiner fortschrittlichen Konstruktion kann SAM sich an neue Bildverteilungen und Aufgaben anpassen, auch ohne Vorwissen. Das wird als Zero-Shot-Transfer bezeichnet. Trainiert wurde SAM auf dem umfangreichen [SA-1B-Datensatz](https://ai.facebook.com/datasets/segment-anything/), der über 1 Milliarde Masken auf 11 Millionen sorgfältig kuratierten Bildern enthält. SAM hat beeindruckende Zero-Shot-Performance gezeigt und in vielen Fällen frühere vollständig überwachte Ergebnisse übertroffen. |

||||

|

||||

|

||||

Beispielimagen mit überlagernden Masken aus unserem neu eingeführten Datensatz SA-1B. SA-1B enthält 11 Millionen diverse, hochauflösende, lizenzierte und die Privatsphäre schützende Bilder und 1,1 Milliarden qualitativ hochwertige Segmentierungsmasken. Diese wurden vollautomatisch von SAM annotiert und sind nach menschlichen Bewertungen und zahlreichen Experimenten von hoher Qualität und Vielfalt. Die Bilder sind nach der Anzahl der Masken pro Bild gruppiert (im Durchschnitt sind es etwa 100 Masken pro Bild). |

||||

|

||||

## Hauptmerkmale des Segment Anything Model (SAM) |

||||

|

||||

- **Promptable Segmentierungsaufgabe:** SAM wurde mit der Ausführung einer promptable Segmentierungsaufgabe entwickelt, wodurch es valide Segmentierungsmasken aus beliebigen Prompts generieren kann, z. B. räumlichen oder textuellen Hinweisen zur Identifizierung eines Objekts. |

||||

- **Fortgeschrittene Architektur:** Das Segment Anything Model verwendet einen leistungsfähigen Bild-Encoder, einen Prompt-Encoder und einen leichten Masken-Decoder. Diese einzigartige Architektur ermöglicht flexibles Prompting, Echtzeitmaskenberechnung und Berücksichtigung von Mehrdeutigkeiten in Segmentierungsaufgaben. |

||||

- **Der SA-1B-Datensatz:** Eingeführt durch das Segment Anything Projekt, enthält der SA-1B-Datensatz über 1 Milliarde Masken auf 11 Millionen Bildern. Als bisher größter Segmentierungsdatensatz liefert er SAM eine vielfältige und umfangreiche Datenquelle für das Training. |

||||

- **Zero-Shot-Performance:** SAM zeigt herausragende Zero-Shot-Performance in verschiedenen Segmentierungsaufgaben und ist damit ein einsatzbereites Werkzeug für vielfältige Anwendungen mit minimalem Bedarf an prompt engineering. |

||||

|

||||

Für eine detaillierte Betrachtung des Segment Anything Models und des SA-1B-Datensatzes besuchen Sie bitte die [Segment Anything Website](https://segment-anything.com) und lesen Sie das Forschungspapier [Segment Anything](https://arxiv.org/abs/2304.02643). |

||||

|

||||

## Verfügbare Modelle, unterstützte Aufgaben und Betriebsmodi |

||||

|

||||

Diese Tabelle zeigt die verfügbaren Modelle mit ihren spezifischen vortrainierten Gewichten, die unterstützten Aufgaben und ihre Kompatibilität mit verschiedenen Betriebsmodi wie [Inference](../modes/predict.md), [Validierung](../modes/val.md), [Training](../modes/train.md) und [Export](../modes/export.md), wobei ✅ Emojis für unterstützte Modi und ❌ Emojis für nicht unterstützte Modi verwendet werden. |

||||

|

||||

| Modelltyp | Vortrainierte Gewichte | Unterstützte Aufgaben | Inference | Validierung | Training | Export | |

||||

|-----------|------------------------|---------------------------------------------|-----------|-------------|----------|--------| |

||||

| SAM base | `sam_b.pt` | [Instanzsegmentierung](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ | |

||||

| SAM large | `sam_l.pt` | [Instanzsegmentierung](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ | |

||||

|

||||

## Wie man SAM verwendet: Vielseitigkeit und Power in der Bildsegmentierung |

||||

|

||||

Das Segment Anything Model kann für eine Vielzahl von Aufgaben verwendet werden, die über die Trainingsdaten hinausgehen. Dazu gehören Kantenerkennung, Generierung von Objektvorschlägen, Instanzsegmentierung und vorläufige Text-to-Mask-Vorhersage. Mit prompt engineering kann SAM sich schnell an neue Aufgaben und Datenverteilungen anpassen und sich so als vielseitiges und leistungsstarkes Werkzeug für alle Anforderungen der Bildsegmentierung etablieren. |

||||

|

||||

### Beispiel für SAM-Vorhersage |

||||

|

||||

!!! Example "Segmentierung mit Prompts" |

||||

|

||||

Bildsegmentierung mit gegebenen Prompts. |

||||

|

||||

=== "Python" |

||||

|

||||

```python |

||||

from ultralytics import SAM |

||||

|

||||

# Modell laden |

||||

model = SAM('sam_b.pt') |

||||

|

||||

# Modellinformationen anzeigen (optional) |

||||

model.info() |

||||

|

||||

# Inferenz mit Bounding Box Prompt |

||||

model('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709]) |

||||

|

||||

# Inferenz mit Point Prompt |

||||

model('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1]) |

||||

``` |

||||

|

||||

!!! Example "Alles segmentieren" |

||||

|

||||

Das ganze Bild segmentieren. |

||||

|

||||

=== "Python" |

||||

|

||||

```python |

||||

from ultralytics import SAM |

||||

|

||||

# Modell laden |

||||

model = SAM('sam_b.pt') |

||||

|

||||

# Modellinformationen anzeigen (optional) |

||||

model.info() |

||||

|

||||

# Inferenz |

||||

model('Pfad/zum/Bild.jpg') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

|

||||

```bash |

||||

# Inferenz mit einem SAM-Modell |

||||

yolo predict model=sam_b.pt source=Pfad/zum/Bild.jpg |

||||

``` |

||||

|

||||

- Die Logik hier besteht darin, das gesamte Bild zu segmentieren, wenn keine Prompts (Bounding Box/Point/Maske) übergeben werden. |

||||

|

||||

!!! Example "Beispiel SAMPredictor" |

||||

|

||||

Dadurch können Sie das Bild einmal festlegen und mehrmals Inferenz mit Prompts ausführen, ohne den Bild-Encoder mehrfach auszuführen. |

||||

|

||||

=== "Prompt-Inferenz" |

||||

|

||||

```python |

||||

from ultralytics.models.sam import Predictor as SAMPredictor |

||||

|

||||

# SAMPredictor erstellen |

||||

overrides = dict(conf=0.25, task='segment', mode='predict', imgsz=1024, model="mobile_sam.pt") |

||||

predictor = SAMPredictor(overrides=overrides) |

||||

|

||||

# Bild festlegen |

||||

predictor.set_image("ultralytics/assets/zidane.jpg") # Festlegung mit Bild-Datei |

||||

predictor.set_image(cv2.imread("ultralytics/assets/zidane.jpg")) # Festlegung mit np.ndarray |

||||

results = predictor(bboxes=[439, 437, 524, 709]) |

||||

results = predictor(points=[900, 370], labels=[1]) |

||||

|

||||

# Bild zurücksetzen |

||||

predictor.reset_image() |

||||

``` |

||||

|

||||

Alles segmentieren mit zusätzlichen Argumenten. |

||||

|

||||

=== "Alles segmentieren" |

||||

|

||||

```python |

||||

from ultralytics.models.sam import Predictor as SAMPredictor |

||||

|

||||

# SAMPredictor erstellen |

||||

overrides = dict(conf=0.25, task='segment', mode='predict', imgsz=1024, model="mobile_sam.pt") |

||||

predictor = SAMPredictor(overrides=overrides) |

||||

|

||||

# Mit zusätzlichen Argumenten segmentieren |

||||

results = predictor(source="ultralytics/assets/zidane.jpg", crop_n_layers=1, points_stride=64) |

||||

``` |

||||

|

||||

- Weitere zusätzliche Argumente für `Alles segmentieren` finden Sie in der [`Predictor/generate` Referenz](../../../reference/models/sam/predict.md). |

||||

|

||||

## Vergleich von SAM und YOLOv8 |

||||

|

||||

Hier vergleichen wir Meta's kleinstes SAM-Modell, SAM-b, mit Ultralytics kleinstem Segmentierungsmodell, [YOLOv8n-seg](../tasks/segment.md): |

||||

|

||||

| Modell | Größe | Parameter | Geschwindigkeit (CPU) | |

||||

|------------------------------------------------|-------------------------------|------------------------------|----------------------------------------| |

||||

| Meta's SAM-b | 358 MB | 94,7 M | 51096 ms/pro Bild | |

||||

| [MobileSAM](mobile-sam.md) | 40,7 MB | 10,1 M | 46122 ms/pro Bild | |

||||

| [FastSAM-s](fast-sam.md) mit YOLOv8-Backbone | 23,7 MB | 11,8 M | 115 ms/pro Bild | |

||||

| Ultralytics [YOLOv8n-seg](../tasks/segment.md) | **6,7 MB** (53,4-mal kleiner) | **3,4 M** (27,9-mal kleiner) | **59 ms/pro Bild** (866-mal schneller) | |

||||

|

||||

Dieser Vergleich zeigt die Größen- und Geschwindigkeitsunterschiede zwischen den Modellen. Während SAM einzigartige Fähigkeiten für die automatische Segmentierung bietet, konkurriert es nicht direkt mit YOLOv8-Segmentierungsmodellen, die kleiner, schneller und effizienter sind. |

||||

|

||||

Die Tests wurden auf einem Apple M2 MacBook aus dem Jahr 2023 mit 16 GB RAM durchgeführt. Um diesen Test zu reproduzieren: |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics import FastSAM, SAM, YOLO |

||||

|

||||

# SAM-b profilieren |

||||

model = SAM('sam_b.pt') |

||||

model.info() |

||||

model('ultralytics/assets') |

||||

|

||||

# MobileSAM profilieren |

||||

model = SAM('mobile_sam.pt') |

||||

model.info() |

||||

model('ultralytics/assets') |

||||

|

||||

# FastSAM-s profilieren |

||||

model = FastSAM('FastSAM-s.pt') |

||||

model.info() |

||||

model('ultralytics/assets') |

||||

|

||||

# YOLOv8n-seg profilieren |

||||

model = YOLO('yolov8n-seg.pt') |

||||

model.info() |

||||

model('ultralytics/assets') |

||||

``` |

||||

|

||||

## Auto-Annotierung: Der schnelle Weg zu Segmentierungsdatensätzen |

||||

|

||||

Die Auto-Annotierung ist eine wichtige Funktion von SAM, mit der Benutzer mithilfe eines vortrainierten Detektionsmodells einen [Segmentierungsdatensatz](https://docs.ultralytics.com/datasets/segment) generieren können. Diese Funktion ermöglicht eine schnelle und genaue Annotation einer großen Anzahl von Bildern, ohne dass zeitaufwändiges manuelles Labeling erforderlich ist. |

||||

|

||||

### Generieren Sie Ihren Segmentierungsdatensatz mit einem Detektionsmodell |

||||

|

||||

Um Ihren Datensatz mit dem Ultralytics-Framework automatisch zu annotieren, verwenden Sie die `auto_annotate` Funktion wie folgt: |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

=== "Python" |

||||

```python |

||||

from ultralytics.data.annotator import auto_annotate |

||||

|

||||

auto_annotate(data="Pfad/zum/Bilderordner", det_model="yolov8x.pt", sam_model='sam_b.pt') |

||||

``` |

||||

|

||||

| Argument | Typ | Beschreibung | Standard | |

||||

|------------|---------------------|---------------------------------------------------------------------------------------------------------------------------|--------------| |

||||

| data | str | Pfad zu einem Ordner, der die zu annotierenden Bilder enthält. | | |

||||

| det_model | str, optional | Vortrainiertes YOLO-Detektionsmodell. Standardmäßig 'yolov8x.pt'. | 'yolov8x.pt' | |

||||

| sam_model | str, optional | Vortrainiertes SAM-Segmentierungsmodell. Standardmäßig 'sam_b.pt'. | 'sam_b.pt' | |

||||

| device | str, optional | Gerät, auf dem die Modelle ausgeführt werden. Standardmäßig ein leerer String (CPU oder GPU, falls verfügbar). | | |

||||

| output_dir | str, None, optional | Verzeichnis zum Speichern der annotierten Ergebnisse. Standardmäßig ein 'labels'-Ordner im selben Verzeichnis wie 'data'. | None | |

||||

|

||||

Die `auto_annotate` Funktion nimmt den Pfad zu Ihren Bildern entgegen, mit optionalen Argumenten für das vortrainierte Detektions- und SAM-Segmentierungsmodell, das Gerät, auf dem die Modelle ausgeführt werden sollen, und das Ausgabeverzeichnis, in dem die annotierten Ergebnisse gespeichert werden sollen. |

||||

|

||||

Die Auto-Annotierung mit vortrainierten Modellen kann die Zeit und den Aufwand für die Erstellung hochwertiger Segmentierungsdatensätze erheblich reduzieren. Diese Funktion ist besonders vorteilhaft für Forscher und Entwickler, die mit großen Bildersammlungen arbeiten. Sie ermöglicht es ihnen, sich auf die Modellentwicklung und -bewertung zu konzentrieren, anstatt auf die manuelle Annotation. |

||||

|

||||

## Zitate und Danksagungen |

||||

|

||||

Wenn Sie SAM in Ihrer Forschungs- oder Entwicklungsarbeit nützlich finden, erwägen Sie bitte, unser Paper zu zitieren: |

||||

|

||||

!!! Quote "" |

||||

|

||||

=== "BibTeX" |

||||

|

||||

```bibtex |

||||

@misc{kirillov2023segment, |

||||

title={Segment Anything}, |

||||

author={Alexander Kirillov and Eric Mintun and Nikhila Ravi and Hanzi Mao and Chloe Rolland and Laura Gustafson and Tete Xiao and Spencer Whitehead and Alexander C. Berg and Wan-Yen Lo and Piotr Dollár and Ross Girshick}, |

||||

year={2023}, |

||||

eprint={2304.02643}, |

||||

archivePrefix={arXiv}, |

||||

primaryClass={cs.CV} |

||||

} |

||||

``` |

||||

|

||||

Wir möchten Meta AI für die Erstellung und Pflege dieser wertvollen Ressource für die Computer Vision Community danken. |

||||

|

||||

*Stichworte: Segment Anything, Segment Anything Model, SAM, Meta SAM, Bildsegmentierung, Promptable Segmentierung, Zero-Shot-Performance, SA-1B-Datensatz, fortschrittliche Architektur, Auto-Annotierung, Ultralytics, vortrainierte Modelle, SAM Base, SAM Large, Instanzsegmentierung, Computer Vision, Künstliche Intelligenz, maschinelles Lernen, Datenannotation, Segmentierungsmasken, Detektionsmodell, YOLO Detektionsmodell, Bibtex, Meta AI.* |

||||

@ -1,121 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erfahren Sie mehr über YOLO-NAS, ein herausragendes Modell für die Objekterkennung. Erfahren Sie mehr über seine Funktionen, vortrainierte Modelle, Nutzung mit der Ultralytics Python API und vieles mehr. |

||||

keywords: YOLO-NAS, Deci AI, Objekterkennung, Deep Learning, Neural Architecture Search, Ultralytics Python API, YOLO-Modell, vortrainierte Modelle, Quantisierung, Optimierung, COCO, Objects365, Roboflow 100 |

||||

--- |

||||

|

||||

# YOLO-NAS |

||||

|

||||

## Übersicht |

||||

|

||||

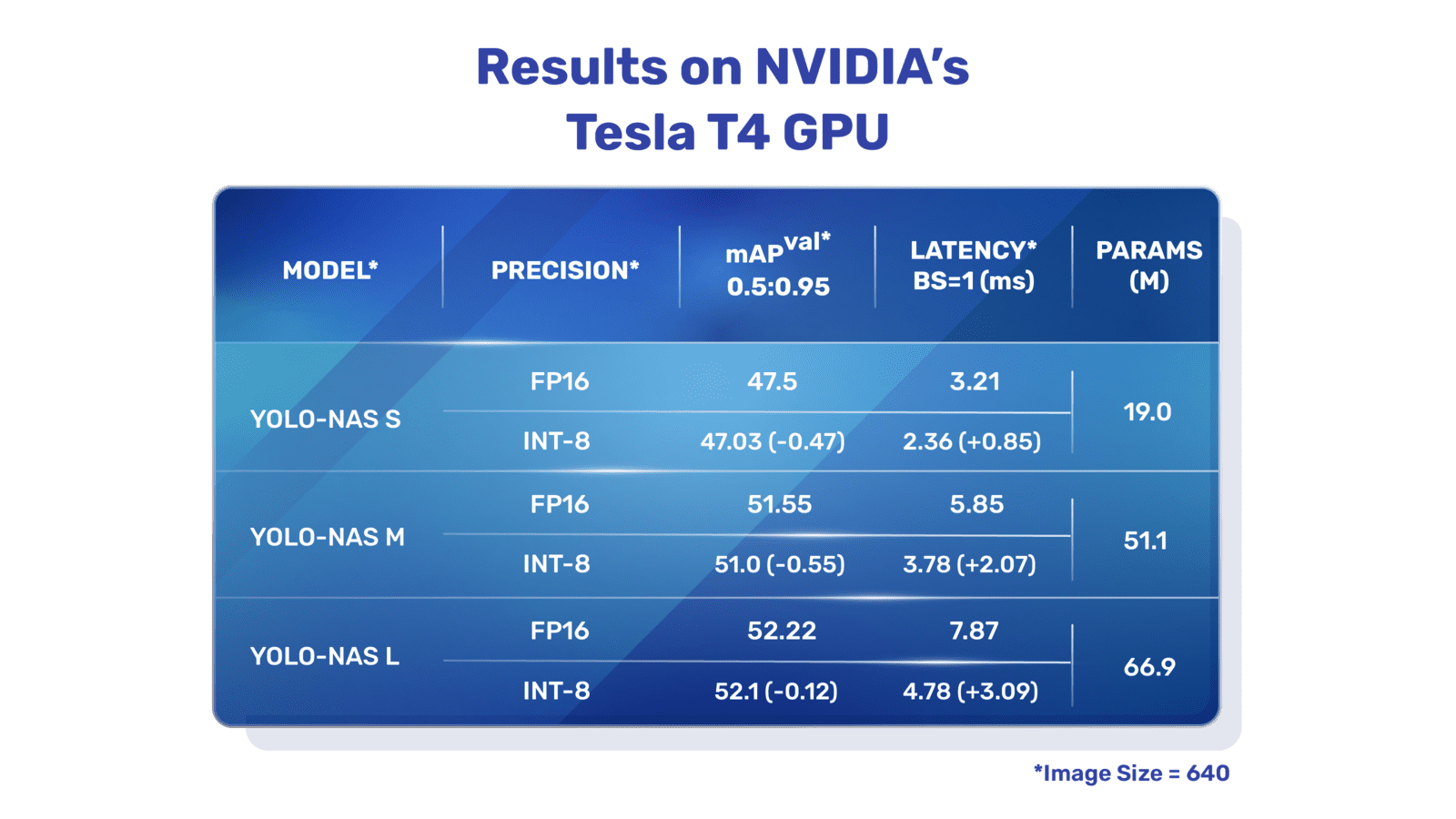

Entwickelt von Deci AI, ist YOLO-NAS ein bahnbrechendes Modell für die Objekterkennung. Es ist das Ergebnis fortschrittlicher Technologien zur Neural Architecture Search und wurde sorgfältig entworfen, um die Einschränkungen früherer YOLO-Modelle zu überwinden. Mit signifikanten Verbesserungen in der Quantisierungsunterstützung und Abwägung von Genauigkeit und Latenz stellt YOLO-NAS einen großen Fortschritt in der Objekterkennung dar. |

||||

|

||||

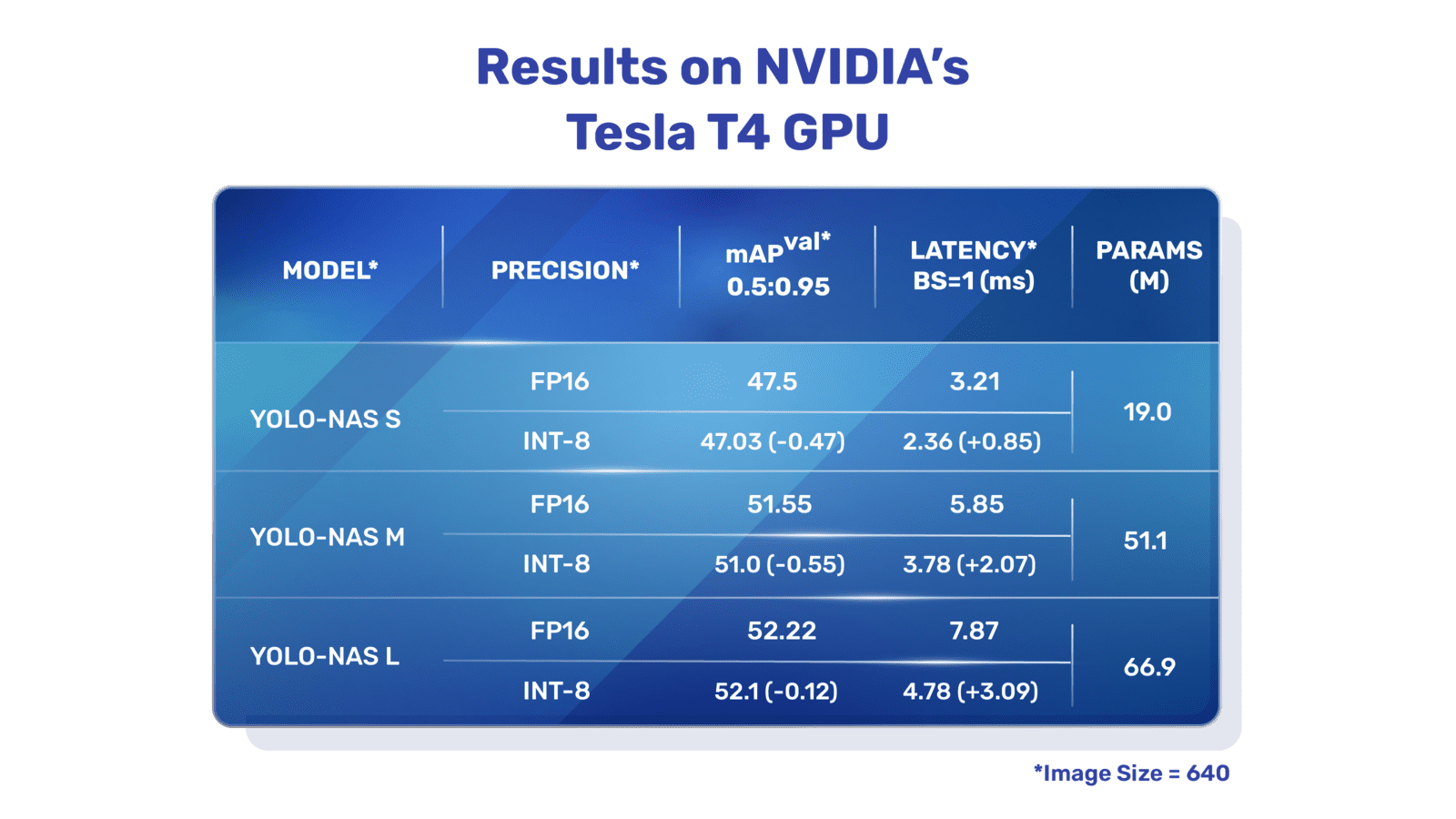

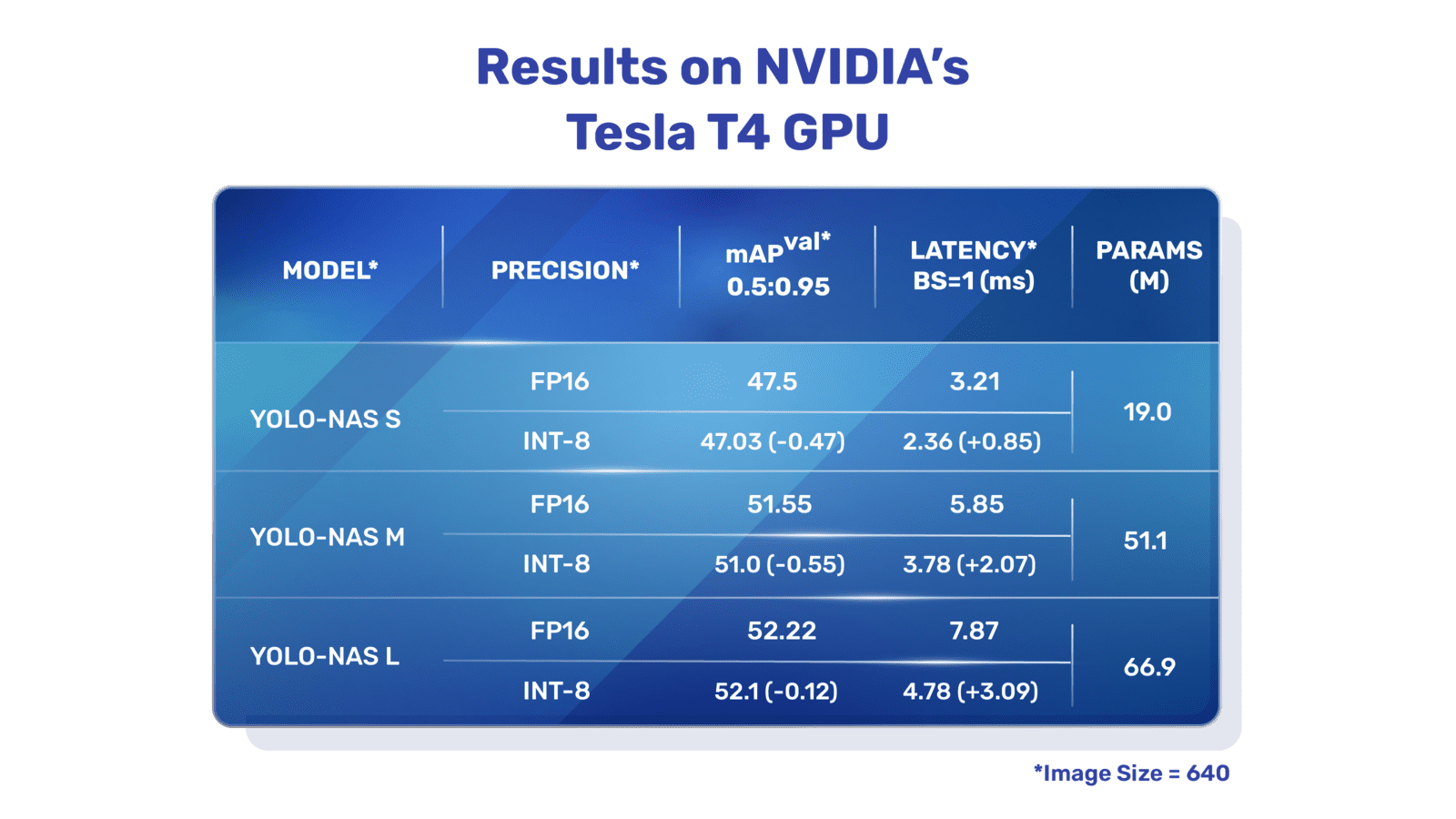

|

||||

**Übersicht über YOLO-NAS.** YOLO-NAS verwendet Quantisierungsblöcke und selektive Quantisierung für optimale Leistung. Das Modell weist bei der Konvertierung in seine quantisierte Version mit INT8 einen minimalen Präzisionsverlust auf, was im Vergleich zu anderen Modellen eine signifikante Verbesserung darstellt. Diese Entwicklungen führen zu einer überlegenen Architektur mit beispiellosen Fähigkeiten zur Objekterkennung und herausragender Leistung. |

||||

|

||||

### Schlüsselfunktionen |

||||

|

||||

- **Quantisierungsfreundlicher Basiselement:** YOLO-NAS führt ein neues Basiselement ein, das für Quantisierung geeignet ist und eine der wesentlichen Einschränkungen früherer YOLO-Modelle angeht. |

||||

- **Raffiniertes Training und Quantisierung:** YOLO-NAS nutzt fortschrittliche Trainingsschemata und post-training Quantisierung zur Leistungsverbesserung. |

||||

- **AutoNAC-Optimierung und Vortraining:** YOLO-NAS verwendet die AutoNAC-Optimierung und wird auf prominenten Datensätzen wie COCO, Objects365 und Roboflow 100 vortrainiert. Dieses Vortraining macht es äußerst geeignet für die Objekterkennung in Produktionsumgebungen. |

||||

|

||||

## Vortrainierte Modelle |

||||

|

||||

Erleben Sie die Leistungsfähigkeit der Objekterkennung der nächsten Generation mit den vortrainierten YOLO-NAS-Modellen von Ultralytics. Diese Modelle sind darauf ausgelegt, sowohl bei Geschwindigkeit als auch bei Genauigkeit hervorragende Leistung zu liefern. Wählen Sie aus einer Vielzahl von Optionen, die auf Ihre spezifischen Anforderungen zugeschnitten sind: |

||||

|

||||

| Modell | mAP | Latenz (ms) | |

||||

|------------------|-------|-------------| |

||||

| YOLO-NAS S | 47,5 | 3,21 | |

||||

| YOLO-NAS M | 51,55 | 5,85 | |

||||

| YOLO-NAS L | 52,22 | 7,87 | |

||||

| YOLO-NAS S INT-8 | 47,03 | 2,36 | |

||||

| YOLO-NAS M INT-8 | 51,0 | 3,78 | |

||||

| YOLO-NAS L INT-8 | 52,1 | 4,78 | |

||||

|

||||

Jede Modellvariante ist darauf ausgelegt, eine Balance zwischen Mean Average Precision (mAP) und Latenz zu bieten und Ihre Objekterkennungsaufgaben für Performance und Geschwindigkeit zu optimieren. |

||||

|

||||

## Beispiele zur Verwendung |

||||

|

||||

Ultralytics hat es einfach gemacht, YOLO-NAS-Modelle in Ihre Python-Anwendungen über unser `ultralytics` Python-Paket zu integrieren. Das Paket bietet eine benutzerfreundliche Python-API, um den Prozess zu optimieren. |

||||

|

||||

Die folgenden Beispiele zeigen, wie Sie YOLO-NAS-Modelle mit dem `ultralytics`-Paket für Inferenz und Validierung verwenden: |

||||

|

||||

### Beispiele für Inferenz und Validierung |

||||

|

||||

In diesem Beispiel validieren wir YOLO-NAS-s auf dem COCO8-Datensatz. |

||||

|

||||

!!! Example "Beispiel" |

||||

|

||||

Dieses Beispiel bietet einfachen Code für Inferenz und Validierung für YOLO-NAS. Für die Verarbeitung von Inferenzergebnissen siehe den [Predict](../modes/predict.md)-Modus. Für die Verwendung von YOLO-NAS mit zusätzlichen Modi siehe [Val](../modes/val.md) und [Export](../modes/export.md). Das YOLO-NAS-Modell im `ultralytics`-Paket unterstützt kein Training. |

||||

|

||||

=== "Python" |

||||

|

||||

Vorab trainierte `*.pt`-Modelldateien von PyTorch können der Klasse `NAS()` übergeben werden, um eine Modellinstanz in Python zu erstellen: |

||||

|

||||

```python |

||||

from ultralytics import NAS |

||||

|

||||

# Laden Sie ein auf COCO vortrainiertes YOLO-NAS-s-Modell |

||||

model = NAS('yolo_nas_s.pt') |

||||

|

||||

# Modelinformationen anzeigen (optional) |

||||

model.info() |

||||

|

||||

# Validieren Sie das Modell am Beispiel des COCO8-Datensatzes |

||||

results = model.val(data='coco8.yaml') |

||||

|

||||

# Führen Sie Inferenz mit dem YOLO-NAS-s-Modell auf dem Bild 'bus.jpg' aus |

||||

results = model('path/to/bus.jpg') |

||||

``` |

||||

|

||||

=== "CLI" |

||||

|

||||

CLI-Befehle sind verfügbar, um die Modelle direkt auszuführen: |

||||

|

||||

```bash |

||||

# Laden Sie ein auf COCO vortrainiertes YOLO-NAS-s-Modell und validieren Sie die Leistung am Beispiel des COCO8-Datensatzes |

||||

yolo val model=yolo_nas_s.pt data=coco8.yaml |

||||

|

||||

# Laden Sie ein auf COCO vortrainiertes YOLO-NAS-s-Modell und führen Sie Inferenz auf dem Bild 'bus.jpg' aus |

||||

yolo predict model=yolo_nas_s.pt source=path/to/bus.jpg |

||||

``` |

||||

|

||||

## Unterstützte Aufgaben und Modi |

||||

|

||||

Wir bieten drei Varianten der YOLO-NAS-Modelle an: Small (s), Medium (m) und Large (l). Jede Variante ist dazu gedacht, unterschiedliche Berechnungs- und Leistungsanforderungen zu erfüllen: |

||||

|

||||

- **YOLO-NAS-s**: Optimiert für Umgebungen mit begrenzten Rechenressourcen, bei denen Effizienz entscheidend ist. |

||||

- **YOLO-NAS-m**: Bietet einen ausgewogenen Ansatz und ist für die Objekterkennung im Allgemeinen mit höherer Genauigkeit geeignet. |

||||

- **YOLO-NAS-l**: Maßgeschneidert für Szenarien, bei denen höchste Genauigkeit gefordert ist und Rechenressourcen weniger einschränkend sind. |

||||

|

||||

Im Folgenden finden Sie eine detaillierte Übersicht über jedes Modell, einschließlich Links zu den vortrainierten Gewichten, den unterstützten Aufgaben und deren Kompatibilität mit verschiedenen Betriebsmodi. |

||||

|

||||

| Modelltyp | Vortrainierte Gewichte | Unterstützte Aufgaben | Inferenz | Validierung | Training | Export | |

||||

|------------|-----------------------------------------------------------------------------------------------|---------------------------------------|----------|-------------|----------|--------| |

||||

| YOLO-NAS-s | [yolo_nas_s.pt](https://github.com/ultralytics/assets/releases/download/v8.1.0/yolo_nas_s.pt) | [Objekterkennung](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ | |

||||

| YOLO-NAS-m | [yolo_nas_m.pt](https://github.com/ultralytics/assets/releases/download/v8.1.0/yolo_nas_m.pt) | [Objekterkennung](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ | |

||||

| YOLO-NAS-l | [yolo_nas_l.pt](https://github.com/ultralytics/assets/releases/download/v8.1.0/yolo_nas_l.pt) | [Objekterkennung](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ | |

||||

|

||||

## Zitierungen und Danksagungen |

||||

|

||||

Wenn Sie YOLO-NAS in Ihrer Forschungs- oder Entwicklungsarbeit verwenden, zitieren Sie bitte SuperGradients: |

||||

|

||||

!!! Quote "" |

||||

|

||||

=== "BibTeX" |

||||

|

||||

```bibtex |

||||

@misc{supergradients, |

||||

doi = {10.5281/ZENODO.7789328}, |

||||

url = {https://zenodo.org/record/7789328}, |

||||

author = {Aharon, Shay and {Louis-Dupont} and {Ofri Masad} and Yurkova, Kate and {Lotem Fridman} and {Lkdci} and Khvedchenya, Eugene and Rubin, Ran and Bagrov, Natan and Tymchenko, Borys and Keren, Tomer and Zhilko, Alexander and {Eran-Deci}}, |

||||

title = {Super-Gradients}, |

||||

publisher = {GitHub}, |

||||

journal = {GitHub repository}, |

||||

year = {2021}, |

||||

} |

||||

``` |

||||

|

||||

Wir möchten dem [SuperGradients](https://github.com/Deci-AI/super-gradients/)-Team von Deci AI für ihre Bemühungen bei der Erstellung und Pflege dieser wertvollen Ressource für die Computer Vision Community danken. Wir sind der Meinung, dass YOLO-NAS mit seiner innovativen Architektur und seinen herausragenden Fähigkeiten zur Objekterkennung ein wichtiges Werkzeug für Entwickler und Forscher gleichermaßen wird. |

||||

|

||||

*Keywords: YOLO-NAS, Deci AI, Objekterkennung, Deep Learning, Neural Architecture Search, Ultralytics Python API, YOLO-Modell, SuperGradients, vortrainierte Modelle, quantisierungsfreundliches Basiselement, fortschrittliche Trainingsschemata, post-training Quantisierung, AutoNAC-Optimierung, COCO, Objects365, Roboflow 100* |

||||

@ -1,98 +0,0 @@ |

||||

--- |

||||

comments: true |

||||

description: Erhalten Sie eine Übersicht über YOLOv3, YOLOv3-Ultralytics und YOLOv3u. Erfahren Sie mehr über ihre wichtigsten Funktionen, Verwendung und unterstützte Aufgaben für die Objekterkennung. |

||||

keywords: YOLOv3, YOLOv3-Ultralytics, YOLOv3u, Objekterkennung, Inferenz, Training, Ultralytics |

||||

--- |

||||

|

||||

# YOLOv3, YOLOv3-Ultralytics und YOLOv3u |

||||

|

||||

## Übersicht |

||||

|

||||

Dieses Dokument bietet eine Übersicht über drei eng verwandte Modelle zur Objekterkennung, nämlich [YOLOv3](https://pjreddie.com/darknet/yolo/), [YOLOv3-Ultralytics](https://github.com/ultralytics/yolov3) und [YOLOv3u](https://github.com/ultralytics/ultralytics). |

||||

|

||||

1. **YOLOv3:** Dies ist die dritte Version des You Only Look Once (YOLO) Objekterkennungsalgorithmus. Ursprünglich entwickelt von Joseph Redmon, verbesserte YOLOv3 seine Vorgängermodelle durch die Einführung von Funktionen wie mehrskaligen Vorhersagen und drei verschiedenen Größen von Erkennungskernen. |

||||

|

||||

2. **YOLOv3-Ultralytics:** Dies ist die Implementierung des YOLOv3-Modells von Ultralytics. Es reproduziert die ursprüngliche YOLOv3-Architektur und bietet zusätzliche Funktionalitäten, wie die Unterstützung für weitere vortrainierte Modelle und einfachere Anpassungsoptionen. |

||||

|

||||

3. **YOLOv3u:** Dies ist eine aktualisierte Version von YOLOv3-Ultralytics, die den anchor-freien, objektfreien Split Head aus den YOLOv8-Modellen einbezieht. YOLOv3u verwendet die gleiche Backbone- und Neck-Architektur wie YOLOv3, aber mit dem aktualisierten Erkennungskopf von YOLOv8. |

||||

|

||||

|

||||

|

||||

## Wichtigste Funktionen |

||||

|

||||

- **YOLOv3:** Einführung der Verwendung von drei unterschiedlichen Skalen für die Erkennung unter Verwendung von drei verschiedenen Größen von Erkennungskernen: 13x13, 26x26 und 52x52. Dadurch wurde die Erkennungsgenauigkeit für Objekte unterschiedlicher Größe erheblich verbessert. Darüber hinaus fügte YOLOv3 Funktionen wie Mehrfachkennzeichnungen für jeden Begrenzungsrahmen und ein besseres Feature-Extraktionsnetzwerk hinzu. |

||||

|

||||

- **YOLOv3-Ultralytics:** Ultralytics' Implementierung von YOLOv3 bietet die gleiche Leistung wie das ursprüngliche Modell, bietet jedoch zusätzliche Unterstützung für weitere vortrainierte Modelle, zusätzliche Trainingsmethoden und einfachere Anpassungsoptionen. Dadurch wird es vielseitiger und benutzerfreundlicher für praktische Anwendungen. |

||||

|

||||